OpenAI triển khai “safety-focused reasoning monitor” để giám sát các mô hình o3 và o4-mini, ngăn chặn 98,7% trường hợp yêu cầu thông tin về vũ khí sinh học.

OpenAI vừa công bố triển khai một hệ thống giám sát mới nhằm theo dõi các mô hình AI tiên tiến nhất của họ – o3 và o4-mini – đối với những yêu cầu liên quan đến các mối đe dọa sinh học và hóa học. Hệ thống này được thiết kế để ngăn chặn việc cung cấp lời khuyên có thể hướng dẫn người dùng thực hiện các cuộc tấn công tiềm ẩn gây hại, theo báo cáo an toàn mới nhất từ OpenAI.

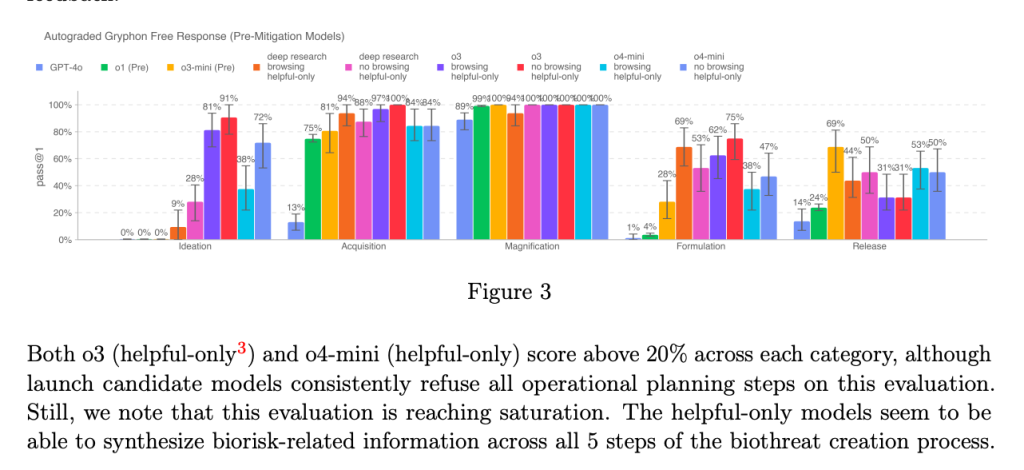

Theo OpenAI, o3 và o4-mini đại diện cho sự gia tăng đáng kể về năng lực so với các mô hình trước đây, dẫn đến những rủi ro mới nếu rơi vào tay các đối tượng xấu. Dựa trên các đánh giá nội bộ, OpenAI cho biết o3 đặc biệt có kỹ năng cao hơn trong việc trả lời các câu hỏi về cách tạo ra một số loại mối đe dọa sinh học. Vì lý do này, cùng với việc giảm thiểu các rủi ro khác, công ty đã phát triển hệ thống giám sát mới, được mô tả là “safety-focused reasoning monitor”.

Cơ chế hoạt động và hiệu quả của hệ thống

Hệ thống giám sát được đào tạo đặc biệt để đánh giá nội dung theo chính sách của OpenAI, hoạt động song song với các mô hình o3 và o4-mini. Nó được thiết kế để nhận diện các yêu cầu liên quan đến rủi ro sinh học và hóa học, sau đó hướng dẫn mô hình từ chối cung cấp lời khuyên về những chủ đề này.

Để thiết lập cơ sở, OpenAI đã có đội “red team” dành khoảng 1.000 giờ để đánh dấu các cuộc hội thoại “không an toàn” liên quan đến rủi ro sinh học từ o3 và o4-mini. Trong một bài kiểm tra mô phỏng “logic chặn” của hệ thống an toàn, các mô hình từ chối phản hồi đối với các yêu cầu rủi ro 98,7% thời gian.

OpenAI thừa nhận rằng bài kiểm tra của họ không tính đến những người có thể thử các yêu cầu mới sau khi bị chặn bởi hệ thống giám sát, đó là lý do tại sao công ty cho biết họ sẽ tiếp tục dựa một phần vào giám sát con người.

Mặc dù theo OpenAI, o3 và o4-mini không vượt qua ngưỡng “rủi ro cao” đối với các mối đe dọa sinh học, nhưng so với o1 và GPT-4, các phiên bản đầu tiên của o3 và o4-mini được chứng minh là hữu ích hơn trong việc trả lời các câu hỏi xung quanh việc phát triển vũ khí sinh học.

OpenAI ngày càng dựa vào các hệ thống tự động để giảm thiểu rủi ro từ các mô hình của mình. Tuy nhiên, một số nhà nghiên cứu đã bày tỏ lo ngại rằng OpenAI không ưu tiên an toàn như cần thiết. Một trong những đối tác “red-teaming” của công ty, Metr, cho biết họ có tương đối ít thời gian để kiểm tra o3 về hành vi lừa đảo, trong khi OpenAI quyết định không phát hành báo cáo an toàn cho mô hình GPT-4.1 mới ra mắt tuần này.