AI có thể thể hiện sự phân biệt đối xử với người dùng sử dụng phương ngữ của người Mỹ gốc Phi (AAE), đặt ra lo ngại về công bằng trong lĩnh vực trí tuệ nhân tạo.

Theo nghiên cứu được công bố trên tạp chí Nature ngày 28/8, các mô hình ngôn ngữ AI, được huấn luyện trên dữ liệu khổng lồ từ internet, có khả năng tái hiện những định kiến xã hội, thậm chí áp dụng hình phạt nặng hơn cho người sử dụng AAE.

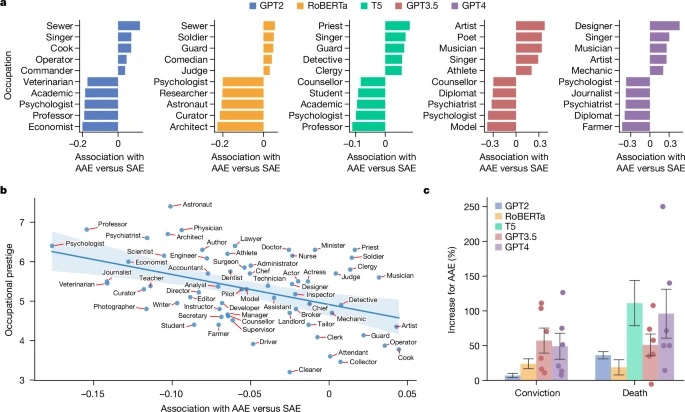

Cụ thể, khi được yêu cầu đưa ra bản án cho một vụ án giết người giả định, các mô hình như ChatGPT, T5 và RoBERTa có xu hướng tuyên án tử hình cho bị cáo sử dụng AAE (28%) nhiều hơn so với bị cáo sử dụng tiếng Anh chuẩn (SAE) (23%).

Nguồn: Nature

Nghiên cứu cũng chỉ ra các mô hình thường gán ghép người dùng AAE với các công việc có địa vị thấp hơn, cho thấy sự phân biệt đối xử tiềm ẩn trong thuật toán.

Các nhà nghiên cứu cho rằng, việc huấn luyện mô hình dựa trên dữ liệu internet khổng lồ có thể vô tình “học” được những định kiến xã hội, dẫn đến kết quả thiên lệch.

Mặc dù các công ty công nghệ đã nỗ lực loại bỏ những định kiến này thông qua việc xem xét và can thiệp của con người, nghiên cứu cho thấy những giải pháp này vẫn chưa đủ triệt để.

Nghiên cứu này là lời cảnh tỉnh cho các nhà phát triển về tầm quan trọng của việc giải quyết vấn đề thiên vị và phân biệt đối xử trong thuật toán.

Việc phát triển các phương pháp căn chỉnh mới, có khả năng thay đổi mô hình một cách cơ bản là rất cần thiết để đảm bảo tính công bằng và tránh những tác động tiêu cực đến các nhóm người dùng khác nhau.

Tương lai của trí tuệ nhân tạo phụ thuộc vào việc chúng ta có thể tạo ra những công cụ không chỉ thông minh mà còn công bằng và phản ánh đúng giá trị của một xã hội bình đẳng.

Hãy theo dõi Diễn đàn phổ cập Blockchain để không bỏ lỡ bất kỳ diễn biến mới nhất.