Nghiên cứu kiểm tra dựa trên từ ngữ “high-surprisal” cho thấy GPT-4 có khả năng đã ghi nhớ nhiều đoạn từ sách và bài báo có bản quyền.

Giữa lúc OpenAI đang phải đối mặt với hàng loạt vụ kiện bản quyền, một nghiên cứu mới vừa được công bố bởi các nhà khoa học đến từ Đại học Washington, Đại học Copenhagen và Stanford có thể sẽ thêm dầu vào lửa cho cuộc tranh cãi về đạo đức và pháp lý trong việc huấn luyện AI.

Phương pháp “bắt quả tang” AI ghi nhớ dữ liệu

Các nhà nghiên cứu đã phát triển một phương pháp mới để xác định liệu các mô hình ngôn ngữ lớn có “ghi nhớ” nội dung đã được sử dụng trong quá trình huấn luyện hay không. Phương pháp này tập trung vào những từ được gọi là “high-surprisal” – những từ hiếm gặp hoặc không thường xuyên xuất hiện trong một ngữ cảnh cụ thể.

Để minh họa, nghiên cứu đưa ra ví dụ về từ “radar” trong câu “Jack and I sat perfectly still with the radar humming” (Jack và tôi ngồi im lặng với tiếng radar kêu vo vo). Từ “radar” được coi là high-surprisal vì về mặt thống kê, nó ít có khả năng xuất hiện trước từ “humming” hơn so với những từ như “engine” (động cơ) hay “radio” (đài).

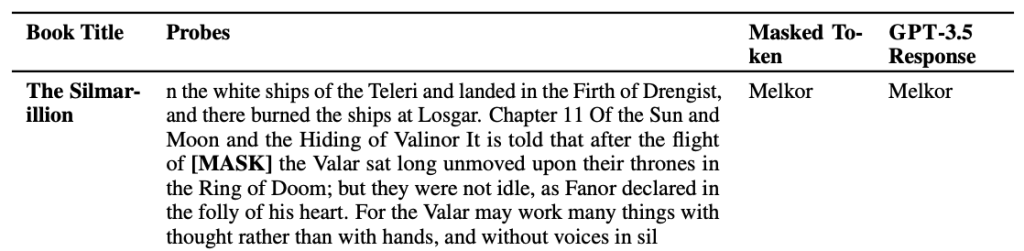

Nhóm nghiên cứu đã thử nghiệm bằng cách xóa các từ high-surprisal khỏi đoạn trích từ sách tiểu thuyết và các bài báo của New York Times, sau đó yêu cầu mô hình như GPT-4 và GPT-3.5 “đoán” những từ đã bị che đi. Nếu mô hình có thể đoán chính xác, điều này gợi ý rằng mô hình đã ghi nhớ đoạn văn đó trong quá trình huấn luyện.

TÍN DỤNG HÌNH ẢNH: OPENAI

Kết quả thử nghiệm cho thấy GPT-4 thể hiện dấu hiệu đã ghi nhớ các phần của sách tiểu thuyết phổ biến, bao gồm cả những cuốn sách trong bộ dữ liệu BookMIA – một tập hợp các mẫu sách điện tử có bản quyền. Nghiên cứu cũng phát hiện rằng mô hình đã ghi nhớ một số phần của các bài báo từ New York Times, mặc dù với tỷ lệ thấp hơn.

Abhilasha Ravichander, nghiên cứu sinh tiến sĩ tại Đại học Washington và đồng tác giả của nghiên cứu, khẳng định rằng phát hiện này đã làm sáng tỏ về “dữ liệu gây tranh cãi” mà các mô hình có thể đã được huấn luyện trên đó. “Để có những mô hình ngôn ngữ lớn đáng tin cậy, chúng ta cần có những mô hình mà chúng ta có thể kiểm tra, đánh giá và khám phá một cách khoa học”, Ravichander nói. “Công trình của chúng tôi nhằm cung cấp một công cụ để kiểm tra các mô hình ngôn ngữ lớn, nhưng thực sự cần có sự minh bạch dữ liệu lớn hơn trong toàn bộ hệ sinh thái.”

Đối với OpenAI, công ty từ lâu đã ủng hộ việc nới lỏng các hạn chế đối với việc phát triển mô hình sử dụng dữ liệu có bản quyền. Mặc dù công ty đã có một số thỏa thuận cấp phép nội dung và cung cấp cơ chế cho phép chủ sở hữu bản quyền đánh dấu nội dung họ không muốn công ty sử dụng cho mục đích đào tạo, OpenAI vẫn tích cực vận động hành lang các chính phủ để hợp pháp hóa quy tắc “sử dụng hợp lý” (fair use) liên quan đến các phương pháp huấn luyện AI.

Nghiên cứu này xuất hiện trong bối cảnh OpenAI đang phải đối mặt với nhiều vụ kiện từ các tác giả, lập trình viên và các chủ sở hữu quyền khác, những người cáo buộc công ty đã sử dụng tác phẩm của họ – sách, mã nguồn và nhiều nội dung khác – để phát triển mô hình mà không xin phép. Khi ngành công nghiệp AI tiếp tục phát triển với tốc độ chóng mặt, những câu hỏi về bản quyền và sử dụng dữ liệu hợp pháp sẽ chỉ trở nên cấp thiết hơn trong tương lai gần.