Lừa đảo tiền mã hóa sử dụng deepfake AI đang bùng nổ trong quý 2/2024, với nhóm tội phạm CryptoCore đã chiếm đoạt hơn 5 triệu USD. SpaceX và MicroStrategy là những “con mồi” ưa thích.

Deepfake AI, công nghệ từng được biết đến qua các video giải trí, nay đã trở thành vũ khí lợi hại của tội phạm mạng. Theo báo cáo quý 2/2024 của Gen Digital, các vụ lừa đảo tiền mã hóa sử dụng deepfake AI đã gia tăng mạnh mẽ. Nhóm tội phạm mạng có tên “CryptoCore” đã lợi dụng công nghệ này để lừa đảo người dùng, chiếm đoạt hơn 5 triệu USD tiền mã hóa.

CryptoCore sử dụng deepfake để tạo ra video giả mạo, khai thác các video chính thức của những nhân vật nổi tiếng như Elon Musk, Michael Saylor, Vitalik Buterin và Larry Fink. Chúng biến các video bình thường thành công cụ lừa đảo, thay thế âm thanh bằng giọng nói do AI tạo ra hoặc trộn lẫn nội dung giả với cảnh quay thật. Những hứa hẹn về lợi nhuận “khủng” từ các khoản đầu tư tiền mã hóa đã dụ dỗ không ít nạn nhân.

Hoạt động của CryptoCore đã trở nên cực kỳ nguy hiểm khi chúng sử dụng các nền tảng mạng xã hội có lượng người theo dõi lớn. Gen Digital cho biết CryptoCore phát tán video lừa đảo trên các nền tảng như YouTube, X (Twitter) và TikTok. Chúng cũng tấn công và chiếm quyền kiểm soát các tài khoản có lượng người theo dõi lớn để phát trực tiếp quảng bá các chiêu trò lừa đảo.

Siggi Stefnisson, Giám đốc công nghệ của Gen Digital, cho biết tội phạm mạng đang đa dạng hoá “bộ công cụ” lừa đảo bằng cách sử dụng AI theo nhiều cách khác nhau để tăng cường các cuộc tấn công. Chúng rất giỏi trong việc khai thác những gì đang diễn ra trong tâm trí của mục tiêu như bầu cử, tình yêu hoặc an ninh tài chính.

“Giờ đây, với AI và các công nghệ mới khác, các chiêu trò lừa đảo ngày càng tinh vi và thuyết phục hơn. Chúng tôi khuyến nghị người dùng nên tự trang bị kiến thức về những mối nguy hiểm từ deepfake và không ngừng nâng cao cảnh giác”, Stefnisson nói.

Đáng chú ý, thiệt hại tài chính tiếp tục gia tăng khi những tổ chức lớn như SpaceX bị nhắm đến. Trong vụ tấn công mạng nhắm vào SpaceX hồi tháng 6, Gen Digital ước tính có khoảng 50 tài khoản YouTube bị chiếm quyền điều khiển, dẫn đến 500 giao dịch trái phép khiến người dùng thiệt hại 1,4 triệu USD.

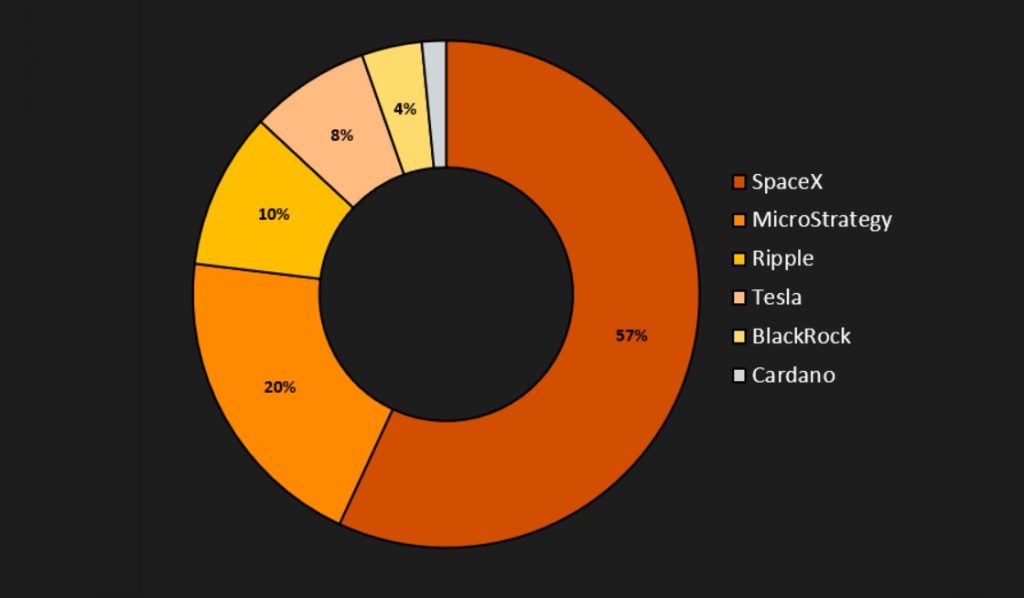

Bên cạnh đó, nghiên cứu chuyên sâu của Avast về CryptoCore vào tháng 8 phát hiện ra, các chủ đề bị khai thác nhiều nhất bằng deepfake AI gồm SpaceX, MicroStrategy, Ripple, Tesla, BlackRock và Cardano. Đây là những tổ chức nổi tiếng, khiến các video giả mạo có mức độ tin cậy cao hơn đối với nạn nhân.

Các vụ tấn công đe dọa an ninh ví tiền mã hóa

Công ty bảo mật Web3, CertiK dự đoán rằng deepfake AI không chỉ giới hạn ở việc giả mạo video và âm thanh, mà còn có thể vượt qua các hệ thống bảo mật tinh vi hơn trong tương lai.

Ví dụ điển hình là việc tin tặc sử dụng deepfake để qua mặt công nghệ nhận diện khuôn mặt trong bảo mật ví tiền mã hóa. Đại diện của CertiK cảnh báo các hệ thống sử dụng công nghệ này cần phải được kiểm tra nghiêm ngặt để chống lại các mối đe dọa từ AI.

Chuyên gia an ninh mạng Luis Corrons từ công ty Norton cũng chia sẻ lo ngại rằng các cuộc tấn công sử dụng deepfake AI sẽ tiếp tục nhắm vào các chủ sở hữu tiền mã hóa. Ông giải thích giao dịch tiền mã hóa thường có giá trị lớn và tính ẩn danh cao, khiến nó trở thành mục tiêu hấp dẫn cho tội phạm mạng. “Đặc biệt, việc thiếu các quy định pháp lý cụ thể càng làm tăng rủi ro, tạo cơ hội cho tội phạm tấn công mà ít bị trừng phạt”, Corrons nhấn mạnh.

Biện pháp phòng ngừa và nhận thức của người dùng

Mặc dù deepfake AI đang trở thành mối đe dọa nghiêm trọng, các chuyên gia bảo mật khẳng định rằng người dùng vẫn có thể bảo vệ bản thân bằng các biện pháp phù hợp. Đại diện của CertiK cho rằng việc nâng cao nhận thức về các công cụ và dịch vụ phòng chống là bước quan trọng đầu tiên.

Người dùng nên cảnh giác với những yêu cầu không mong muốn về tiền bạc hoặc thông tin cá nhân từ các nguồn không rõ ràng. Đặc biệt, kích hoạt phương thức xác thực hai yếu tố cho các tài khoản quan trọng là một cách hiệu quả để tăng cường bảo mật.

Luis Corrons cũng đưa ra các gợi ý cụ thể để phát hiện deepfake. Ông khuyến nghị người dùng chú ý đến các dấu hiệu như chuyển động mắt, biểu cảm khuôn mặt hoặc cử động cơ thể không tự nhiên, bởi công nghệ deepfake thường không thể tái hiện hoàn hảo các chuyển động này. Ngoài ra, hình dạng cơ thể không hài hòa, hoặc âm thanh không khớp với hình ảnh cũng là những dấu hiệu đáng ngờ của deepfake AI.

Corrons nhấn mạnh rằng việc trang bị kiến thức và cẩn trọng khi tiếp nhận thông tin sẽ giúp người dùng tự bảo vệ mình trong thời đại của deepfake AI.