Các gã khổng lồ công nghệ đang thu về lợi nhuận khổng lồ từ dịch vụ đám mây dựa trên AI, song đồng thời phải duy trì chi phí khổng lồ để phát triển công nghệ này.

Sự phát triển AI đang trở thành một “hố tiền khổng lồ”, như Bloomberg đã chính xác miêu tả, làm nổi bật thực tế kinh tế phức tạp đằng sau cuộc cách mạng AI hiện nay.

Lòng tham về trí tuệ nhân tạo tổng quát (AGI) đã thúc đẩy các công ty phát triển các hệ thống ngày càng phức tạp, đơn cử như mô hình ngôn ngữ lớn (LLM) GPT-4 hay Gemini. Những mô hình này đòi hỏi sức mạnh tính toán khổng lồ, đẩy giá phần cứng lên mức chưa từng thấy.

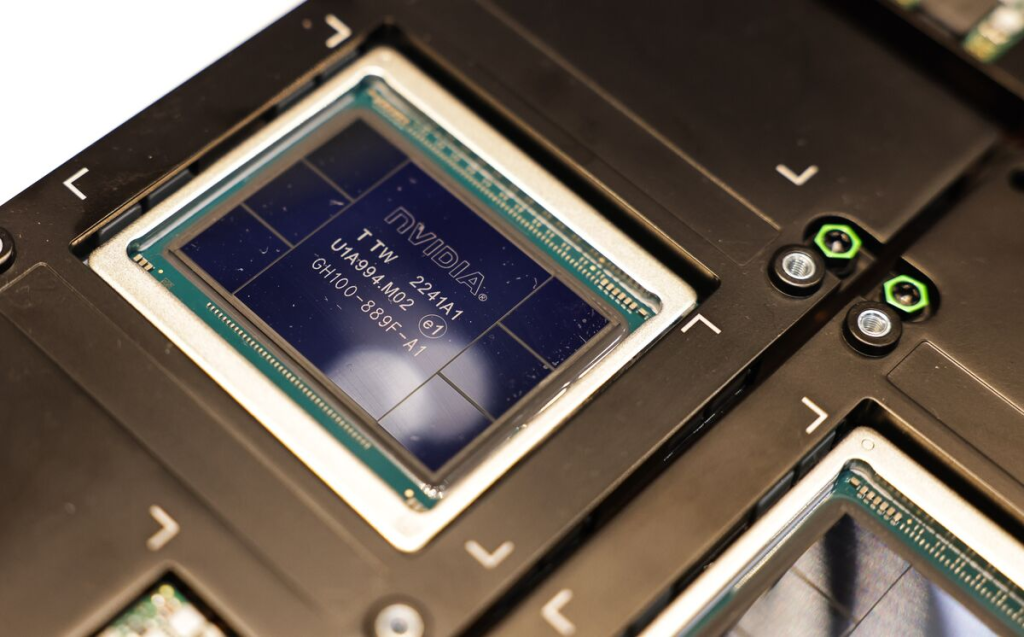

Như một hệ quả tất yếu, nhu cầu về chip AI chuyên dụng, chủ yếu là bộ xử lý đồ họa (GPU), đã tăng vọt. Nvidia, nhà sản xuất hàng đầu trong lĩnh vực này, đã thấy giá trị thị trường của mình tăng vọt khi các công ty công nghệ đua nhau tìm kiếm các thành phần thiết yếu này.

Chip đồ họa H100 của họ, tiêu chuẩn vàng cho huấn luyện mô hình AI được bán với giá ước tính 30.000 USD. Với một số nhà bán lẻ, họ cung cấp với giá gấp nhiều lần.

Sự khan hiếm chip toàn cầu chỉ làm trầm trọng thêm vấn đề này, một số công ty phải chờ đợi hàng tháng để có được phần cứng cần thiết. Giám đốc điều hành Meta, Mark Zuckerberg, trước đây đã nói rằng công ty của ông dự định mua 350.000 chip H100 vào cuối năm nay để hỗ trợ các nỗ lực nghiên cứu AI của mình. Ngay cả khi ông nhận được chiết khấu mua hàng theo lô, con số đó vẫn lên tới hàng tỷ USD.

Bên cạnh đó, sự thúc đẩy phát triển AI tiên tiến cũng khơi mào cuộc chạy đua trong thiết kế chip. Các công ty như Google và Amazon đầu tư mạnh để phát triển bộ xử lý AI riêng của họ, nhằm có được lợi thế cạnh tranh và giảm sự phụ thuộc vào các nhà cung cấp bên thứ ba. Xu hướng phát triển chip tùy chỉnh này tạo thêm một lớp phức tạp và chi phí khác cho quá trình phát triển AI.

Gánh nặng cơ sở hạ tầng

Thách thức về phần cứng không chỉ dừng lại ở việc mua chip. Phạm vi của các mô hình AI hiện đại đòi hỏi các trung tâm dữ liệu quy mô lớn, đi kèm với những trở ngại kỹ thuật. Các cơ sở này phải được thiết kế để xử lý khối lượng tính toán cực lớn đồng thời quản lý hiệu quả sự tỏa nhiệt và tiêu thụ năng lượng. Khi các mô hình lớn hơn, nhu cầu về năng lượng cũng tăng lên đáng kể, làm tăng đáng kể chi phí hoạt động và tác động đến môi trường.

Theo ông Dario Amodei, CEO của Anthropic, đối thủ của OpenAI, trong một cuộc phỏng vấn hồi đầu tháng Tư, chi phí để huấn luyện các mô hình AI hiện nay khoảng 100 triệu USD, nhưng các mô hình đang được phát triển có thể tiêu tốn tới 1 tỷ USD. Ông dự đoán vào năm 2025 và 2026, chi phí này có thể tăng lên tới 5 hoặc 10 tỷ USD.

Ngoài ra, dữ liệu – “dòng máu” của các hệ thống AI, cũng đặt ra những thách thức công nghệ riêng. Nhu cầu về các tập dữ liệu lớn và chất lượng cao đã khiến các công ty phải đầu tư mạnh vào công nghệ thu thập, làm sạch và chú thích dữ liệu.

Một số công ty đang phát triển các công cụ tạo dữ liệu tổng hợp tinh vi để bổ sung cho dữ liệu thực tế, càng làm gia tăng chi phí nghiên cứu và phát triển.

Tốc độ phát triển AI nhanh chóng cũng có nghĩa là cơ sở hạ tầng và công cụ nhanh chóng trở nên lỗi thời. Các công ty phải liên tục nâng cấp hệ thống của họ và huấn luyện lại các mô hình của họ để duy trì tính cạnh tranh, tạo ra một chu kỳ đầu tư và lỗi thời liên tục.

Lợi nhuận tiềm năng

Dù chi phí khổng lồ, các gã khổng lồ công nghệ đang chứng minh AI có thể là động lực gia tăng thu nhập thực sự.

Microsoft và Alphabet đã báo cáo sự tăng trưởng đáng kể trong các doanh nghiệp đám mây của họ, chủ yếu là do nhu cầu ngày càng tăng về các dịch vụ AI. Điều này cho thấy mặc dù khoản đầu tư ban đầu vào công nghệ AI là rất lớn, tiềm năng lợi nhuận đủ hấp dẫn để biện minh cho chi phí.

Tuy nhiên, chi phí cao trong phát triển AI cũng đặt ra mối lo ngại về sự tập trung thị trường. Chi phí liên quan đến nghiên cứu AI tiên tiến có thể hạn chế sự đổi mới chỉ dành cho một số công ty có nguồn vốn dồi dào, đồng thời cũng có thể dập tắt sự cạnh tranh và đa dạng trong lĩnh vực này.

Dù vậy, ngành công nghiệp đang tập trung phát triển các công nghệ AI hiệu quả hơn để giải quyết những thách thức về chi phí. Các kỹ thuật như học tập ít lần, học tập chuyển giao và các kiến trúc mô hình tiết kiệm năng lượng đang được nghiên cứu nhằm giảm chi phí và nâng cao hiệu quả.

Hơn nữa, xu hướng chuyển sang AI cục bộ – chạy các mô hình AI trên các thiết bị cục bộ thay vì trên đám mây – có thể giúp phân tán khối lượng tính toán và giảm áp lực lên các trung tâm dữ liệu tập trung. Tuy nhiên, điều này đòi hỏi các đổi mới kỹ thuật riêng trong thiết kế chip và tối ưu hóa phần mềm.

Rõ ràng là tương lai của AI sẽ được định hình không chỉ bởi những bước đột phá trong các thuật toán và thiết kế mô hình mà còn bởi khả năng của chúng ta trong việc vượt qua những trở ngại công nghệ và tài chính khổng lồ đi kèm với việc mở rộng hệ thống AI.

Các công ty nếu có thể vượt qua những thách thức này một cách hiệu quả, có khả năng sẽ trở thành những nhà lãnh đạo trong giai đoạn tiếp theo của cuộc cách mạng AI.